Sin sorpresas de por medio, el procesador tope de gama seguirá asentado en una configuración de 64 núcleos y 128 hilos de procesamiento. Este recibe el nombre de EPYC 7763 y llega con unas frecuencias Base/Turbo de 2.45/3.50 GHz con 32 MB de caché L2, 256 MB de caché L3 y un TDP de 280W.

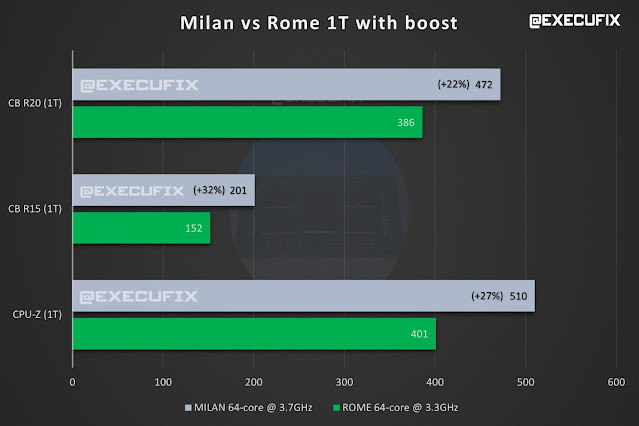

En términos de rendimiento, gracias a la microarquitectura Zen3, y a unas frecuencias Turbo más altas, vemos notorias mejoras de rendimiento. Si nos centramos en el IPC, es decir, a igualdad de frecuencias (2.40 GHz), en Cinebench R20 se experimenta una mejora de rendimiento de un 11%; en Cinebench R15 del 18% y en CPU-Z del 13%. Con las frecuencias Turbo de fábrica, estas mejoras de rendimiento son de un +22%/+32%/+27% de forma respectiva, mientras que en multinúcleo las mejoras son menos llamativas, con un 9% en Cinebench R20 y un 11% en Cinebench R15.

Si buscamos un software más moderno que aproveche las bondades del, AMD EPYC 7763 , pues nada mejor que mirar CineBench R23, donde alcanzó una puntación para un núcleo de 1215 puntos y una puntuación multinúcleo de 87.878 puntos, Como referencia, es un 76% más rápido que el Intel Xeon 8280L Platinum (Cascade Lake-SP) de 28 núcleos y 56 hilos @ 2,70/5,60 GHz con TDP de 205W. Si tenemos en cuenta que las nuevas CPUs Intel Xeon con núcleos Sunny Cove (Ice Lake) prometen una mejora de IPC del 18%, pues poco puede hacer Intel aquí.

vía: @ExecuFix

Saludos.